线代知识回顾¶

Vectors¶

一般记作 \(\vec{a}\) 或者 \(\mathbf{a}\)。

Normalization¶

记作 \(\lVert \vec{a} \rVert\)。

Unit vector: \(\hat{a} = \vec{a} / \lVert \vec{a} \rVert\)。

Dot Product¶

\(\vec{a} \cdot \vec{b} = \lVert \vec{a} \rVert \lVert \vec{b} \rVert \cos \langle \vec{a}, \vec{b} \rangle\)。

\(\cos \langle \vec{a}, \vec{b} \rangle = \frac{\vec{a} \cdot \vec{b}}{\lVert \vec{a} \rVert \lVert \vec{b} \rVert}\)。

对于单位向量,\(\cos \langle \vec{a}, \vec{b} \rangle = \vec{a} \cdot \vec{b}\)。

Projection¶

将 \(\vec{b}\) 投影到 \(\vec{a}\) 上:

Matrices¶

Identity Matrix and Inverses¶

\(A A^{-1} = A^{-1} A = I\)

\((A B)^{-1} = B^{-1} A^{-1}\)

Transformations¶

实质是对每个点的坐标进行变换。

\(x' = Ax\)

Scaling¶

Reflection¶

沿 y 轴反射:

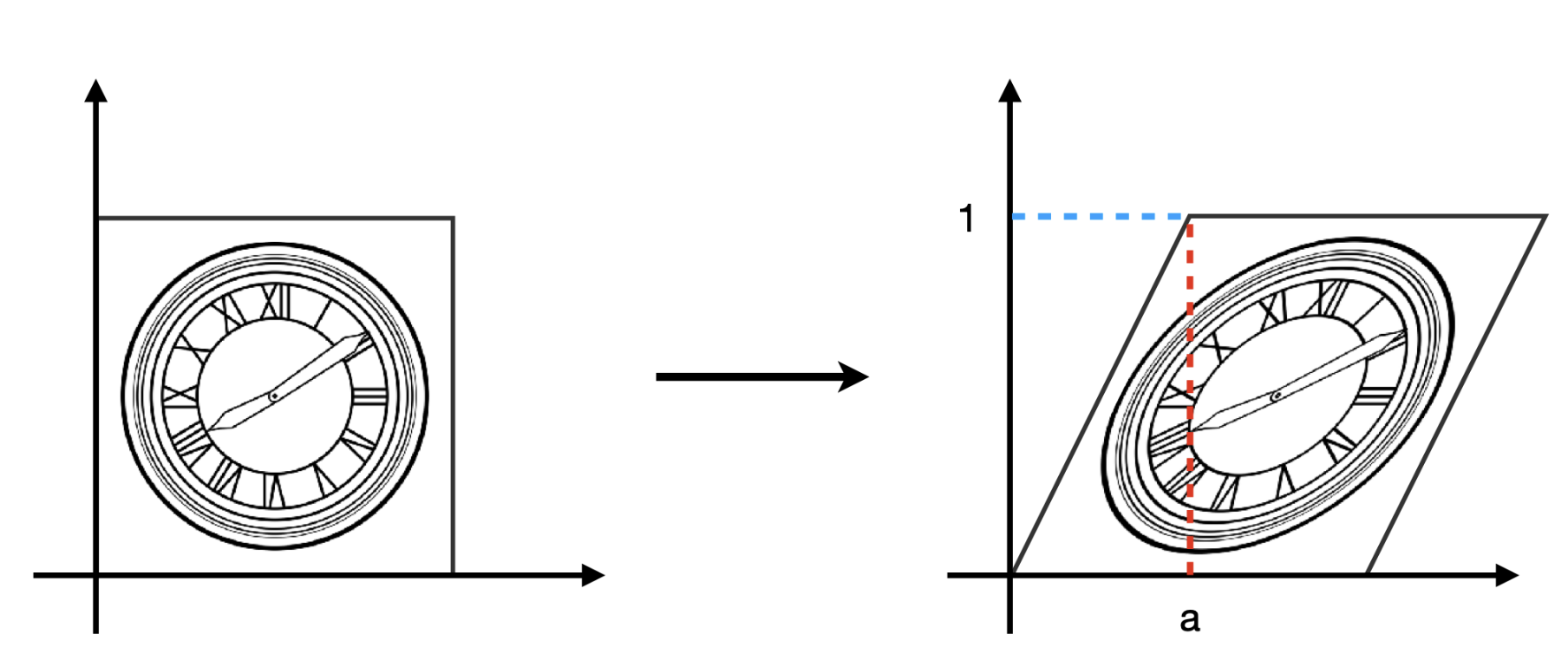

Shear¶

Rotation¶

以原点为中心逆时针旋转 \(\theta\):

Linear Transforms¶

\(\vec{v'} = M \vec{v}\)

Translation¶

平移不是线性变换。

Affine Transforms¶

仿射变换是线性变换和平移的组合。

Homogeneous Coordinates¶

齐次坐标,将 2D 坐标转换为 3D 坐标。

Inverse Transform¶

将变换后的坐标转换回原坐标,其代表的变换矩阵为原变换矩阵的逆矩阵。

Matrix Determinants¶

3 维空间中,三个向量组成的平行六面体的体积,为三个向量组成的行列式的绝对值。

Eigenvectors and Eigenvalues¶

特征值和特征向量。

\(\lambda\) 为特征值,\(\vec{v}\) 为特征向量。

Eigen Decomposition¶

其中,\(Q\) 为特征向量矩阵,\(\Lambda\) 为特征值矩阵。

PCA (Principal Component Analysis)¶

主成分分析,是一种降维技术。寻找特征空间中的方向,使得数据在这些方向上的投影方差最大。

先将数据中心化,即将横纵坐标减去均值。

矩阵 \(A^T A\) 有两个特征向量,对应两个特征值。

其中较大的特征值对应的特征向量即为主成分,特征值为此方向上的方差。